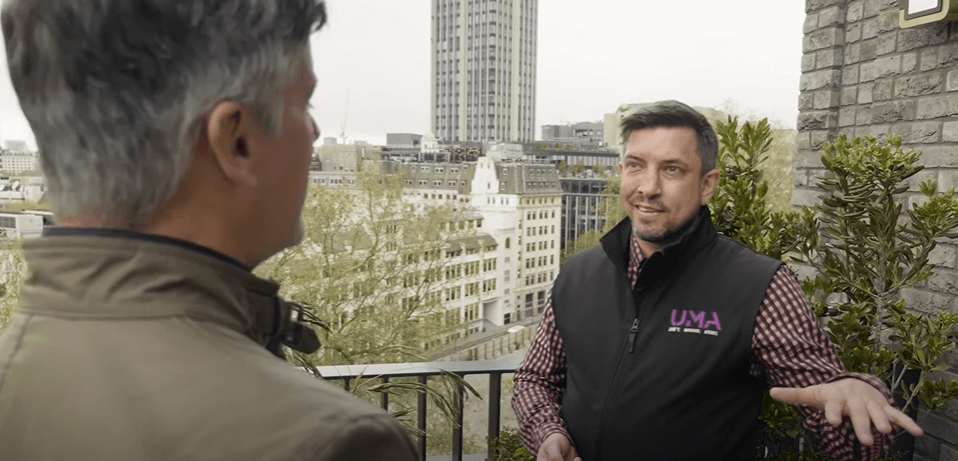

Historie sukcesu

Liderzy branż i całych rynków powierzają nam swoje cyfrowe projekty, bo wiedzą, że jesteśmy w stanie zapewnić im kompleksowe rozwiązania dostosowane do ich konkretnych potrzeb i do profilu ich działalności. Za każdą historią sukcesu stoi pragmatyczne podejście, które stawia klienta i jego potrzeby w centrum uwagi.